Points de contrôle

Total Confirmed Cases

/ 10

Worst Affected Areas

/ 10

Identifying Hotspots

/ 10

Fatality Ratio

/ 10

Identifying specific day

/ 10

Finding days with zero net new cases

/ 10

Doubling rate

/ 10

Recovery rate

/ 10

CDGR - Cumulative Daily Growth Rate

/ 10

Create a Looker Studio report

/ 10

Dégager des insights des données BigQuery : atelier challenge

- GSP787

- Présentation

- Préparation

- Scénario

- Tâche 1 : Total de cas confirmés

- Tâche 2 : Régions les plus touchées

- Tâche 3 : Identifier les régions les plus sensibles

- Tâche 4 : Taux de létalité

- Tâche 5 : Identification d'une journée spécifique

- Tâche 6 : Journées sans augmentation du nombre de nouveaux cas

- Tâche 7 : Doublement du taux

- Tâche 8 : Taux de guérison

- Tâche 9 : Taux de croissance journalier cumulé

- Tâche 10 : Créer un rapport Looker Studio

- Félicitations !

GSP787

Présentation

Vous allez devoir effectuer une série de tâches dans le délai imparti. Aucune instruction détaillée ne sera fournie : vous disposerez d'un scénario et d'un ensemble de tâches. À vous de déterminer comment procéder ! Vous saurez si vous avez exécuté correctement les différentes tâches grâce au score calculé automatiquement (affiché sur cette page).

Pour atteindre le score de 100 %, vous devez réaliser l'ensemble des tâches dans le délai imparti.

Lorsque vous participez à un atelier challenge, vous n'étudiez pas de nouveaux concepts Google Cloud. Pour élaborer la solution qui vous permettra de résoudre le challenge présenté, utilisez les compétences acquises au cours des ateliers du cours correspondant. Vous devrez vous appuyer sur vos nouvelles compétences. Il vous faudra modifier les requêtes erronées.

Cet atelier est recommandé aux participants inscrits au cours Derive Insights from BigQuery Data et qui veulent obtenir le badge de compétence associé. Êtes-vous prêt pour le challenge ?

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre vous-même les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Nous vous fournissons des identifiants temporaires pour vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome) ;

- vous disposez d'un temps limité ; une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Scénario

Vous faites partie d'un organisme de santé publique chargé d'identifier les réponses à des requêtes relatives à la pandémie de COVID-19. L'obtention de réponses correctes permettra à votre organisme de planifier et cibler les soins et les programmes de sensibilisation de façon appropriée.

L'ensemble de données et la table utilisés pour cette analyse sont : bigquery-public-data.covid19_open_data.covid19_open_data. Ce dépôt contient des ensembles de données nationales de séries temporelles quotidiennes liées à la COVID-19 à l'échelle mondiale. Il inclut des données sur les catégories démographiques, l'économie, l'épidémiologie, la zone géographique, la santé, les hospitalisations, la mobilité, la réponse gouvernementale et la météo.

Tâche 1 : Total de cas confirmés

- Créez une requête qui répond à la question : "Quel était le total de cas confirmés au

?". La requête doit renvoyer une ligne unique contenant la somme des cas confirmés dans le monde. Le nom de la colonne doit être total_cases_worldwide.

Colonnes de référence :

- cumulative_confirmed

- date

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 2 : Régions les plus touchées

- Créez une requête qui répond à la question : "Combien d'États américains comptaient plus de

morts au ?" Le résultat devra apparaître dans le champ count_of_states.

Colonnes de référence :

- country_name

- subregion1_name (pour les informations sur l'État)

- cumulative_deceased

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 3 : Identifier les régions les plus sensibles

- Créez une requête qui répond à la question : "Quels sont les États américains qui comptaient plus de

cas confirmés au ?" La requête doit renvoyer le nom des États, associé au nombre de cas confirmés, par ordre décroissant. Les champs renvoyés sont state et total_confirmed_cases.

Colonnes de référence :

- country_code

- subregion1_name (pour les informations sur l'État)

- cumulative_confirmed

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 4 : Taux de létalité

- Créez une requête qui répond à la question : "Quel était le taux de létalité en Italie en

2020 ?" Ce taux est défini comme suit : (nombre total de décès/nombre total de cas confirmés) * 100. - Créez une requête qui renvoie le taux pour

2020, dont les champs de sortie sont : total_confirmed_cases, total_deaths et case_fatality_ratio.

Colonnes de référence :

- country_name

- cumulative_confirmed

- cumulative_deceased

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 5 : Identification d'une journée spécifique

- Créez une requête qui répond à la question : "Quel jour le nombre total de décès a-t-il dépassé

en Italie ?" La requête doit renvoyer la date au format aaaa-mm-jj.

Colonnes de référence :

- country_name

- cumulative_deceased

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 6 : Journées sans augmentation du nombre de nouveaux cas

La requête suivante permet de déterminer le nombre de jours en Inde, entre le

- Vous devez modifier et compléter cette requête de façon à obtenir le résultat voulu :

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 7 : Doublement du taux

-

Utilisez la requête précédente comme modèle pour créer une requête permettant de trouver les dates auxquelles le nombre de cas confirmés a augmenté de plus de

% par rapport à la journée précédente (indiquant un doublement du taux sur environ sept jours) aux États-Unis, entre le 22 mars et le 20 avril 2020. La requête doit renvoyer les dates, le nombre de cas confirmés à ces dates, le nombre de cas confirmés la veille de ces dates et le taux d'augmentation correspondant. - Utilisez les noms suivants pour les champs renvoyés : Date, Confirmed_Cases_On_Day, Confirmed_Cases_Previous_Day et Percentage_Increase_In_Cases.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 8 : Taux de guérison

-

Créez une requête pour lister le taux de guérison des pays dans l'ordre décroissant (

maximum) au 10 mai 2020. -

Limitez la requête aux pays dont le nombre de cas confirmés est supérieur à 50 000.

- La requête doit renvoyer les champs suivants : country, recovered_cases, confirmed_cases et recovery_rate.

Colonnes de référence :

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 9 : Taux de croissance journalier cumulé

-

La requête suivante fait une estimation du taux de croissance journalier cumulé au

en France, depuis le premier cas signalé. Le premier cas a été signalé le 24 janvier 2020. -

Le calcul effectué est le suivant :

((last_day_cases/first_day_cases)^1/days_diff)-1)

Où :

-

last_day_casesest le nombre de cas confirmés au 10 mai 2020 -

first_day_casesest le nombre de cas confirmés au 24 janvier 2020 -

days_diffest le nombre de jours entre le 24 janvier et le 10 mai 2020 -

La requête ne s'exécute pas correctement. Pouvez-vous la corriger pour y remédier ?

Cliquez sur Vérifier ma progression pour valider l'objectif.

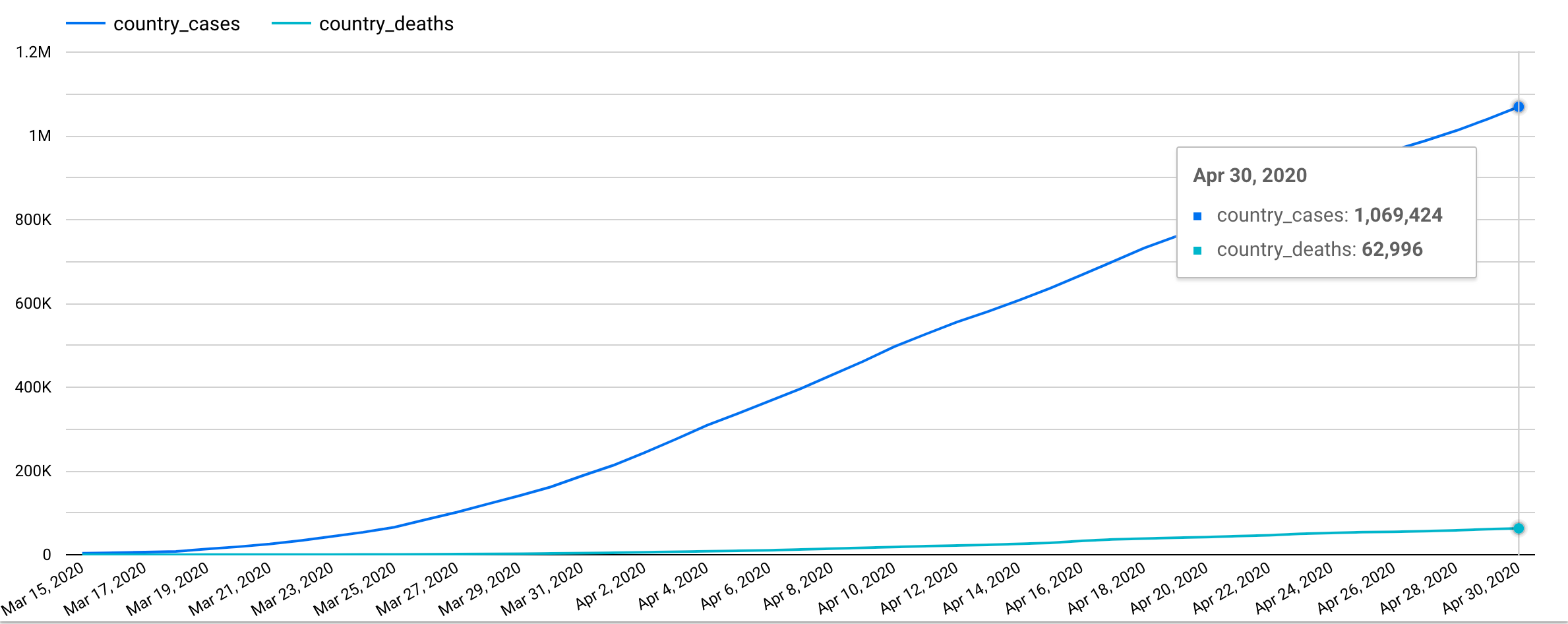

Tâche 10 : Créer un rapport Looker Studio

-

Créez un rapport Looker Studio qui réunit les données suivantes pour les États-Unis :

- Nombre de cas confirmés

- Nombre de décès

- Période :

Cliquez sur Vérifier ma progression pour valider l'objectif.

Félicitations !

Gagnez un badge de compétence

Cet atelier d'auto-formation fait partie du cours Derive Insights from BigQuery Data. Si vous terminez ce cours, vous obtiendrez le badge de compétence ci-dessus attestant de votre réussite. Ajoutez votre badge à votre CV et partagez-le sur les réseaux sociaux en utilisant le hashtag #GoogleCloudBadge.

Ce badge de compétence est associé au parcours de formation Data Analyst de Google. Si vous avez déjà terminé les autres cours de ce parcours de formation, explorez le catalogue Google Cloud Skills Boost pour découvrir plus de vingt autres cours auxquels vous pouvez vous inscrire pour gagner un badge de compétence.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 25 mars 2024

Dernier test de l'atelier : 26 septembre 2023

Copyright 2024 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.