Points de contrôle

Create a Cloud Storage bucket

/ 25

Create Cloud Composer environment

/ 25

Uploading the DAG to Cloud Storage

/ 25

Exploring DAG runs

/ 25

Cloud Composer : Qwik Start – Console

- GSP261

- Aperçu

- Objectifs

- Préparation

- Tâche 1 : Créer un environnement Cloud Composer

- Tâche 2 : Airflow et concepts fondamentaux

- Tâche 3 : Définir le workflow

- Tâche 4 : Afficher les informations concernant l'environnement

- Tâche 5 : Utiliser l'interface utilisateur d'Airflow

- Tâche 6 : Définir les variables Airflow

- Tâche 7 : Importer le DAG dans Cloud Storage

- Tester vos connaissances

- Supprimer l'environnement Cloud Composer

- Félicitations !

- Étapes suivantes

GSP261

Aperçu

Les workflows sont une notion courante dans l'analyse de données ; ils impliquent l'ingestion, la transformation et l'analyse de données pour déduire les informations significatives. Dans Google Cloud, l'hébergement des workflows s'effectue dans Cloud Composer, version hébergée d'Apache Airflow, l'outil de workflow Open Source communément utilisé.

Dans cet atelier, vous allez configurer un environnement Cloud Composer à l'aide de la console Cloud. Vous allez ensuite utiliser Cloud Composer pour mettre en place un workflow simple qui vérifie l'existence d'un fichier de données, crée un cluster Cloud Dataproc, exécute un job de décompte de mots Apache Hadoop sur un cluster Cloud Dataproc, puis supprime ce cluster.

Objectifs

Dans cet atelier, vous apprendrez à effectuer les tâches suivantes :

- Créer l'environnement Cloud Composer à l'aide de la console Cloud

- Afficher et exécuter le graphe orienté acyclique (DAG, Directed Acyclic Graph) dans l'interface Web Airflow

- Afficher les résultats du job de décompte dans l'espace de stockage

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre vous-même les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Nous vous fournissons des identifiants temporaires pour vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome) ;

- vous disposez d'un temps limité ; une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, un pop-up s'affiche pour vous permettre de sélectionner un mode de paiement. Sur la gauche, vous trouverez le panneau Détails concernant l'atelier, qui contient les éléments suivants :

- Le bouton Ouvrir la console Google

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google. L'atelier lance les ressources, puis ouvre la page Se connecter dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte. -

Si nécessaire, copiez le nom d'utilisateur inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue Se connecter. Cliquez sur Suivant.

-

Copiez le mot de passe inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue de bienvenue. Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis dans le panneau de gauche. Ne saisissez pas vos identifiants Google Cloud Skills Boost. Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés. -

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas aux essais offerts.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Activer Cloud Shell

Cloud Shell est une machine virtuelle qui contient de nombreux outils pour les développeurs. Elle comprend un répertoire d'accueil persistant de 5 Go et s'exécute sur Google Cloud. Cloud Shell vous permet d'accéder via une ligne de commande à vos ressources Google Cloud.

- Cliquez sur Activer Cloud Shell

en haut de la console Google Cloud.

Une fois connecté, vous êtes en principe authentifié et le projet est défini sur votre ID_PROJET. Le résultat contient une ligne qui déclare YOUR_PROJECT_ID (VOTRE_ID_PROJET) pour cette session :

gcloud est l'outil de ligne de commande pour Google Cloud. Il est préinstallé sur Cloud Shell et permet la complétion par tabulation.

- (Facultatif) Vous pouvez lister les noms des comptes actifs à l'aide de cette commande :

-

Cliquez sur Autoriser.

-

Vous devez à présent obtenir le résultat suivant :

Résultat :

- (Facultatif) Vous pouvez lister les ID de projet à l'aide de cette commande :

Résultat :

Exemple de résultat :

gcloud, dans Google Cloud, accédez au guide de présentation de la gcloud CLI.

Tâche 1 : Créer un environnement Cloud Composer

Dans cette section, vous allez créer un environnement Cloud Composer.

-

Accédez au menu de navigation (

), puis cliquez sur Composer.

-

Cliquez sur CRÉER UN ENVIRONNEMENT et sélectionnez Composer 1 dans la liste déroulante.

-

Définissez les éléments suivants pour votre environnement :

-

Nom :

highcpu -

Emplacement :

-

Version de l'image : sélectionnez la dernière version

-

Zone :

-

Type de machine :

e2-standard-2

-

Conservez les valeurs par défaut de tous les autres paramètres.

- Cliquez sur CRÉER.

Le processus de création de l'environnement est terminé lorsqu'une coche verte apparaît à gauche du nom de l'environnement sur la page "Environnements" de la console Cloud.

La procédure de configuration de l'environnement peut prendre entre 10 et 15 minutes. Poursuivez l'atelier pendant que l'environnement se configure.

Créer un bucket Cloud Storage

Créez un bucket Cloud Storage dans votre projet. Ce bucket servira de sortie pour le job Hadoop fourni par Dataproc.

-

Accédez au menu de navigation > Cloud Storage > Buckets, puis cliquez sur CRÉER.

-

Nommez votre bucket

, créez-le dans la région , puis cliquez sur CRÉER.

Notez bien le nom du bucket Cloud Storage (votre ID de projet), car vous l'utiliserez comme variable Airflow plus tard dans l'atelier.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 2 : Airflow et concepts fondamentaux

En attendant la création de votre environnement Composer, découvrez quelques-uns des termes associés à Airflow.

Airflow est une plate-forme qui permet de créer, de planifier et de surveiller vos workflows de manière programmatique.

Avec Airflow, vous pouvez créer des workflows en tant que graphes de tâches orientés acycliques. Le programmeur Airflow exécute vos tâches sur un tableau de nœuds de calcul tout en suivant les dépendances spécifiées.

Concepts fondamentaux

Un graphe orienté acyclique (DAG, Directed Acyclic Graph) est une collection regroupant toutes les tâches à exécuter et organisée de manière à refléter leurs relations et leurs dépendances.

Description d'une tâche unique, généralement atomique. Par exemple, l'opérateur BashOperator permet d'exécuter une commande Bash.

Instance paramétrée d'un opérateur. Nœud dans le DAG.

Exécution spécifique d'une tâche caractérisée par un DAG, une tâche et un moment précis. Elle est affectée d'un état indicatif : running (exécution en cours), success (réussite), failed (échec), skipped (ignorée), ...

Pour en savoir plus, lisez la documentation sur les concepts.

Tâche 3 : Définir le workflow

Étudions maintenant le workflow que vous allez utiliser. Les workflows Cloud Composer sont constitués de DAG (graphes orientés acycliques). Les DAG sont définis dans des fichiers Python standards placés dans le dossier DAG_FOLDER d'Airflow. Airflow exécute le code de chaque fichier pour créer dynamiquement les objets DAG. Vous pouvez utiliser le nombre de DAG que vous voulez, chacun décrivant un nombre arbitraire de tâches. En général, un DAG correspond à un workflow logique unique.

-

Ouvrez une nouvelle fenêtre Cloud Shell en cliquant sur l'icône Activer Cloud Shell en haut à droite de la console Cloud.

-

Dans Cloud Shell, utilisez l'éditeur de code nano pour créer le fichier

hadoop_tutorial.py:

- Vous trouverez ci-dessous le code du workflow hadoop_tutorial.py, également appelé DAG. Collez le code suivant dans le fichier

hadoop_tutorial.py.

- Enregistrez les modifications, puis quittez nano en appuyant sur CTRL+O, ENTRÉE et CTRL+X, dans cet ordre.

Pour orchestrer les trois tâches de workflow, le DAG importe les opérateurs suivants :

-

DataprocClusterCreateOperator: crée un cluster Cloud Dataproc. -

DataProcHadoopOperator: soumet un job de décompte de mots Hadoop et code le résultat dans un bucket Cloud Storage. -

DataprocClusterDeleteOperator: supprime le cluster pour éviter que des frais Compute Engine ne continuent d'être facturés.

Les tâches sont exécutées de manière séquentielle, comme vous pouvez le voir dans cette section du fichier :

Ce DAG nommé hadoop_tutorial s'exécute une fois par jour :

La valeur start_date transmise à default_dag_args étant définie sur yesterday, Cloud Composer planifie le démarrage du workflow immédiatement après l'importation du DAG.

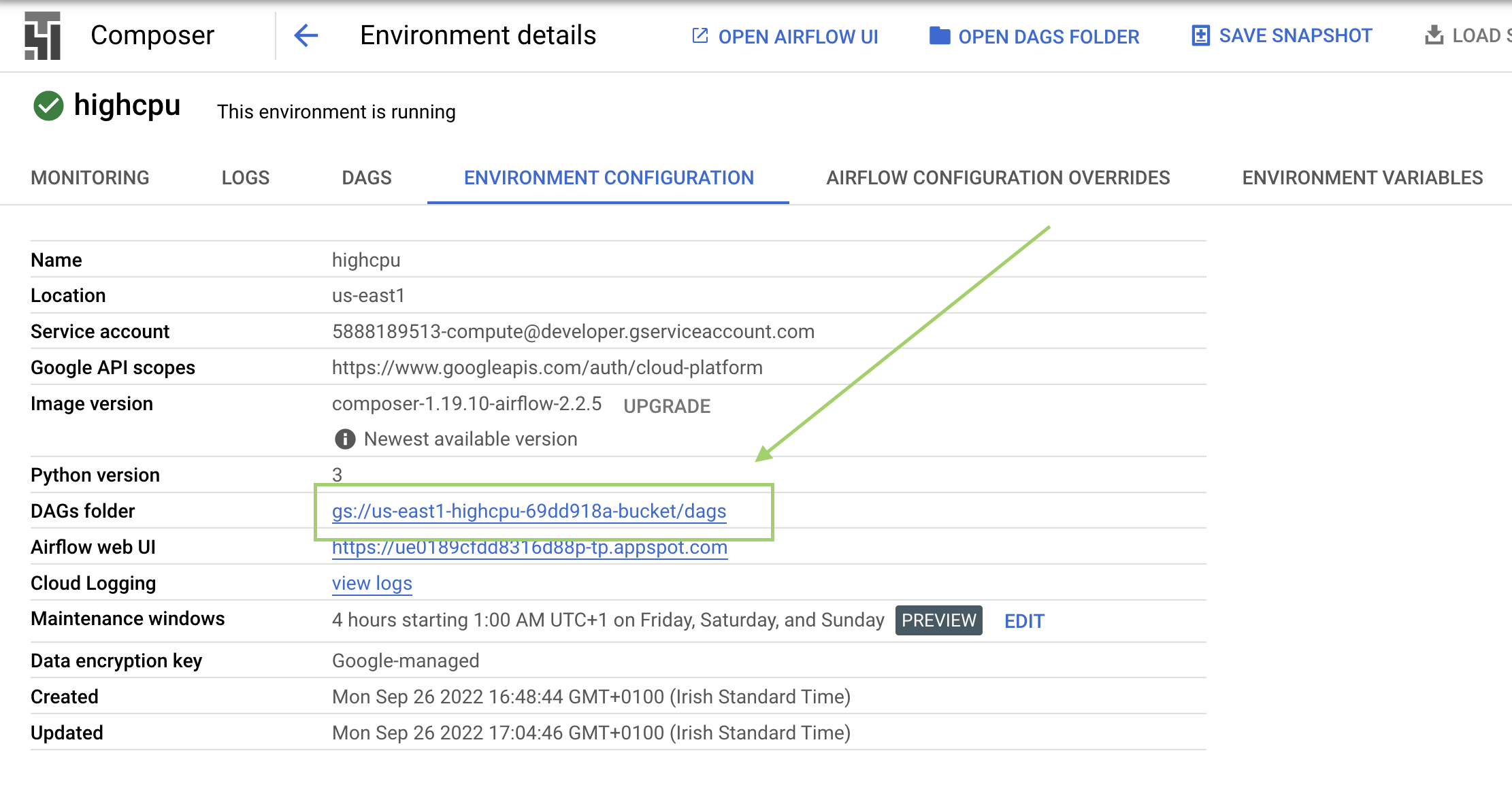

Tâche 4 : Afficher les informations concernant l'environnement

-

Retournez à Composer pour vérifier l'état de votre environnement.

-

Une fois l'environnement créé, cliquez sur son nom (highcpu) pour en afficher les détails.

La page Détails de l'environnement contient des informations telles que l'URL de l'interface Web d'Airflow, l'ID du cluster Kubernetes Engine et un lien vers le dossier des DAG, stocké dans votre bucket.

/dags.Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 5 : Utiliser l'interface utilisateur d'Airflow

Pour accéder à l'interface Web Airflow à l'aide de la console Cloud :

- Retournez à la page Environnements.

- Dans la colonne Serveur Web Airflow associée à l'environnement, cliquez sur Airflow.

- Cliquez sur les identifiants qui vous ont été attribués pour cet atelier.

- L'interface Web Airflow s'ouvre dans une nouvelle fenêtre du navigateur.

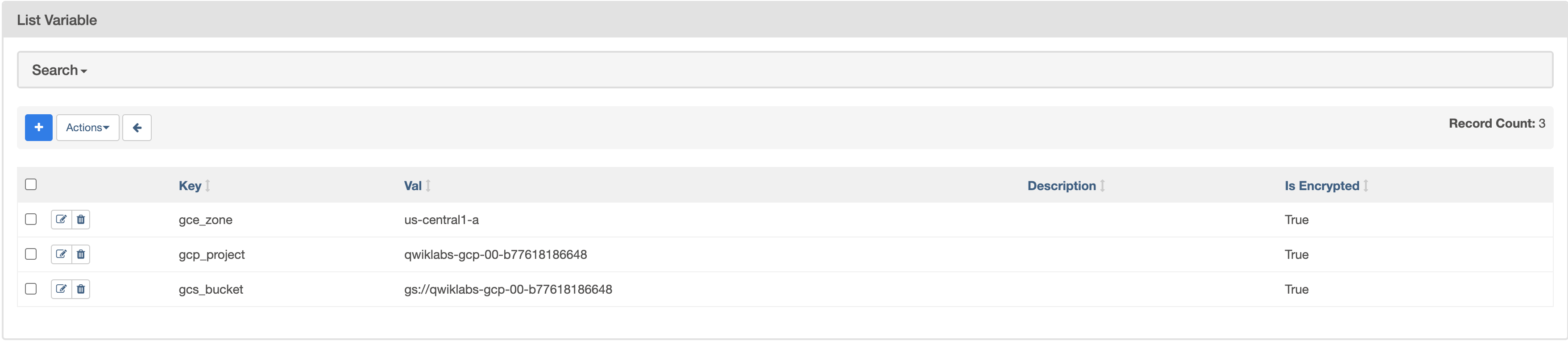

Tâche 6 : Définir les variables Airflow

Les variables Airflow sont un concept spécifique à Airflow, et se distinguent des variables d'environnement.

-

Sélectionnez Admin > Variables dans la barre de menu Airflow, puis cliquez sur + (Ajouter un enregistrement).

-

Créez les variables Airflow

gcp_project,gcs_bucketetgce_zonesuivantes :

|

CLÉ |

VALEUR |

Détails |

|

|

|

Le projet Google Cloud que vous utilisez pour cet atelier Qwik Start. |

|

|

gs:// |

Il s'agit du nom du bucket Cloud Storage que vous avez créé précédemment, qui doit être le même que votre ID de projet, à moins que vous l'ayez modifié. Ce bucket stocke le résultat des jobs Hadoop exécutés sur Dataproc. |

|

|

|

Il s'agit de la zone Compute Engine dans laquelle votre cluster Cloud Dataproc sera créé. Pour choisir une zone différente, reportez-vous à la page Régions et zones disponibles. |

La table des variables doit se présenter comme suit lorsque vous avez terminé :

Tâche 7 : Importer le DAG dans Cloud Storage

Pour importer le DAG, vous importez une copie du fichier hadoop_tutorial.py dans le bucket Cloud Storage qui a été créé automatiquement lors de la création de l'environnement.

-

Vous pouvez le vérifier en accédant à Composer > Environnements.

-

Cliquez sur l'environnement que vous avez créé précédemment. Vous accédez alors à ses détails.

-

Cliquez sur Configuration de l'environnement.

-

Recherchez le dossier

DAGset copiez la valeur de son chemin d'accès. Exécutez ensuite la commande suivante dans Cloud Shell en remplaçant<DAGs_folder_path>par cette valeur :

Cloud Composer ajoute le DAG à Airflow et le planifie automatiquement. Les modifications sont appliquées au DAG après 3 à 5 minutes. Le workflow sera désormais désigné par l'expression composer_hadoop_tutorial.

Vous pourrez voir l'état de la tâche dans l'interface Web Airflow.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Explorer les exécutions du DAG

Lorsque vous importez le fichier DAG dans le dossier dags de Cloud Storage, il est analysé par Cloud Composer. Si aucune erreur n'est détectée, le nom du workflow apparaît dans la liste des DAG, et le workflow est placé en file d'attente en vue d'une exécution immédiate.

Assurez-vous que l'onglet Graphes orientés acycliques de l'interface Web Airflow est actif. Ce processus peut prendre plusieurs minutes. Actualisez le navigateur pour afficher les informations les plus récentes.

-

Dans Airflow, cliquez sur composer_hadoop_tutorial pour ouvrir la page d'informations du DAG. Cette page comprend une représentation graphique des tâches et des dépendances du workflow.

-

Dans la barre d'outils, cliquez sur Vue graphique. Passez la souris sur le graphique de chaque tâche pour afficher l'état de la tâche en question. Notez que la bordure autour de chaque tâche indique également son état (bordure verte = exécution en cours, rouge = échec, etc.).

-

Si nécessaire, activez l'actualisation automatique ou cliquez sur l'icône Actualiser pour vous assurer de disposer des informations les plus récentes. En fonction de l'évolution de l'état des processus, la couleur des bordures change.

Si la couleur de la bordure de create_dataproc_cluster a changé et que l'état est différent de "running" (exécution en cours), relancez le workflow depuis la vue graphique. Si le workflow est à l'état "running", vous n'avez pas besoin d'exécuter les 3 étapes ci-dessous.

- Cliquez sur le graphique create_dataproc_cluster.

- Cliquez sur Clear (Effacer) pour réinitialiser les trois tâches.

- Cliquez ensuite sur OK pour confirmer.

Notez que la couleur de la bordure de create_dataproc_cluster a changé et que l'état est maintenant "running" (exécution en cours).

Vous pouvez aussi surveiller le processus dans la console Cloud.

- Lorsque create_dataproc_cluster passe à l'état "running" (en cours d'exécution), accédez au menu de navigation >Dataproc, puis cliquez sur les éléments suivants :

- Clusters pour surveiller la création et la suppression des clusters. Le cluster créé par le workflow est éphémère : il est supprimé lors de la dernière tâche de ce workflow.

- Jobs pour surveiller le job de décompte de mots Apache Hadoop. Cliquez sur l'ID de job pour afficher la sortie du journal associée au job.

-

Une fois que Dataproc passe à l'état "Running" (Exécution en cours), retournez à Airflow, puis cliquez sur Refresh (Actualiser) pour vérifier que le cluster est créé.

-

Une fois le processus

run_dataproc_hadoopterminé, accédez au menu de navigation, sélectionnez Cloud Storage > Buckets, puis cliquez sur le nom de votre bucket pour afficher les résultats du décompte de mots dans le dossierwordcount.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tester vos connaissances

Testez vos connaissances sur Google Cloud Platform en répondant à notre quiz.

Supprimer l'environnement Cloud Composer

- Revenez à la page Environments dans Composer.

- Cochez la case à côté de votre environnement Composer.

- Cliquez sur SUPPRIMER.

- Confirmez la fenêtre contextuelle en cliquant à nouveau sur DELETE.

Félicitations !

Félicitations ! Dans cet atelier, vous avez créé un environnement Cloud Composer, importé un DAG dans Cloud Storage et exécuté un workflow qui a créé un cluster Cloud Dataproc, exécuté un job de décompte de mots Hadoop et supprimé le cluster. Vous avez également découvert Airflow, ses concepts fondamentaux et son interface Web. Vous pouvez désormais utiliser Cloud Composer pour créer et gérer vos propres workflows.

Étapes suivantes

Cet atelier fait partie d'une série appelée "Qwik Starts". Les ateliers de cette série sont conçus pour vous présenter brièvement les nombreuses fonctionnalités proposées par Google Cloud. Pour suivre un autre atelier, recherchez "Qwik Starts" dans le catalogue.

- Pour afficher la valeur d'une variable, exécutez les variables de la sous-commande CLI Airflow avec l'argument get ou utilisez l'interface Web Airflow.

- Pour en savoir plus sur l'interface Web Airflow, consultez la page Accéder à l'interface utilisateur Web Apache Airflow.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 18 décembre 2023

Dernier test de l'atelier : 18 décembre 2023

Copyright 2024 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.