Points de contrôle

Create a Dataproc cluster (region: us-central1)

/ 50

Submit a Spark Job

/ 25

Update a cluster for 5 worker nodes

/ 25

API Explorer : Créer et mettre à jour un cluster

GSP288

Présentation

Google APIs Explorer est un outil permettant d'explorer différentes API Google de façon interactive. APIs Explorer vous permet d'effectuer les opérations suivantes :

- parcourir rapidement les API et les versions disponibles ;

- consulter les méthodes disponibles pour chaque API, les paramètres compatibles, ainsi que la documentation intégrée ;

- exécuter des requêtes pour chaque méthode et voir les réponses en temps réel ;

- effectuer des appels d'API authentifiés et autorisés ;

- effectuer des recherches dans l'ensemble des services, des méthodes et de vos requêtes récentes afin de trouver rapidement ce dont vous avez besoin.

APIs Explorer utilise sa propre clé API à chaque requête. Lorsque vous l'utilisez pour formuler une requête, APIs Explorer affiche la syntaxe de la requête, qui inclut un espace réservé portant le libellé {YOUR_API_KEY}. Si vous souhaitez réaliser la même requête dans votre application, vous devez remplacer cet espace réservé par votre propre clé API.

Dans cet atelier, vous apprendrez à utiliser un modèle Google APIs Explorer intégré pour appeler l'API Cloud Dataproc afin de créer un cluster et d'exécuter un job Spark simple dans le cluster. Vous découvrirez également comment utiliser le modèle APIs Explorer pour appeler l'API Cloud Dataproc afin de mettre à jour votre cluster.

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre vous-même les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Nous vous fournissons des identifiants temporaires pour vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome) ;

- vous disposez d'un temps limité ; une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, un pop-up s'affiche pour vous permettre de sélectionner un mode de paiement. Sur la gauche, vous trouverez le panneau Détails concernant l'atelier, qui contient les éléments suivants :

- Le bouton Ouvrir la console Google

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google. L'atelier lance les ressources, puis ouvre la page Se connecter dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte. -

Si nécessaire, copiez le nom d'utilisateur inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue Se connecter. Cliquez sur Suivant.

-

Copiez le mot de passe inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue de bienvenue. Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis dans le panneau de gauche. Ne saisissez pas vos identifiants Google Cloud Skills Boost. Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés. -

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas aux essais offerts.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Activer Cloud Shell

Cloud Shell est une machine virtuelle qui contient de nombreux outils pour les développeurs. Elle comprend un répertoire d'accueil persistant de 5 Go et s'exécute sur Google Cloud. Cloud Shell vous permet d'accéder via une ligne de commande à vos ressources Google Cloud.

- Cliquez sur Activer Cloud Shell

en haut de la console Google Cloud.

Une fois connecté, vous êtes en principe authentifié et le projet est défini sur votre ID_PROJET. Le résultat contient une ligne qui déclare YOUR_PROJECT_ID (VOTRE_ID_PROJET) pour cette session :

gcloud est l'outil de ligne de commande pour Google Cloud. Il est préinstallé sur Cloud Shell et permet la complétion par tabulation.

- (Facultatif) Vous pouvez lister les noms des comptes actifs à l'aide de cette commande :

-

Cliquez sur Autoriser.

-

Vous devez à présent obtenir le résultat suivant :

Résultat :

- (Facultatif) Vous pouvez lister les ID de projet à l'aide de cette commande :

Résultat :

Exemple de résultat :

gcloud, dans Google Cloud, accédez au guide de présentation de la gcloud CLI.

Tâche 1 : Ouvrir APIs Explorer

-

Accédez au menu de navigation > APIs & Services (API et services).

-

Faites défiler la liste jusqu'à API Cloud Dataproc, puis cliquez dessus.

-

Assurez-vous que l'API est activée. Si ce n'est pas le cas, cliquez sur Activer.

-

Maintenant que vous avez vérifié que l'API était activée, ouvrez la documentation de référence de l'API REST. Un nouvel onglet s'ouvre et affiche la page de référence de l'API REST pour l'API Cloud Dataproc.

Tâche 2 : Créer un cluster

Dans la section API et documentation de référence à gauche, accédez à Documentation de référence sur REST > v1 > projects.regions.clusters > create pour utiliser la méthode projects.regions.clusters.create, ou utilisez la documentation de référence de la méthode projects.regions.clusters.create pour créer le cluster.

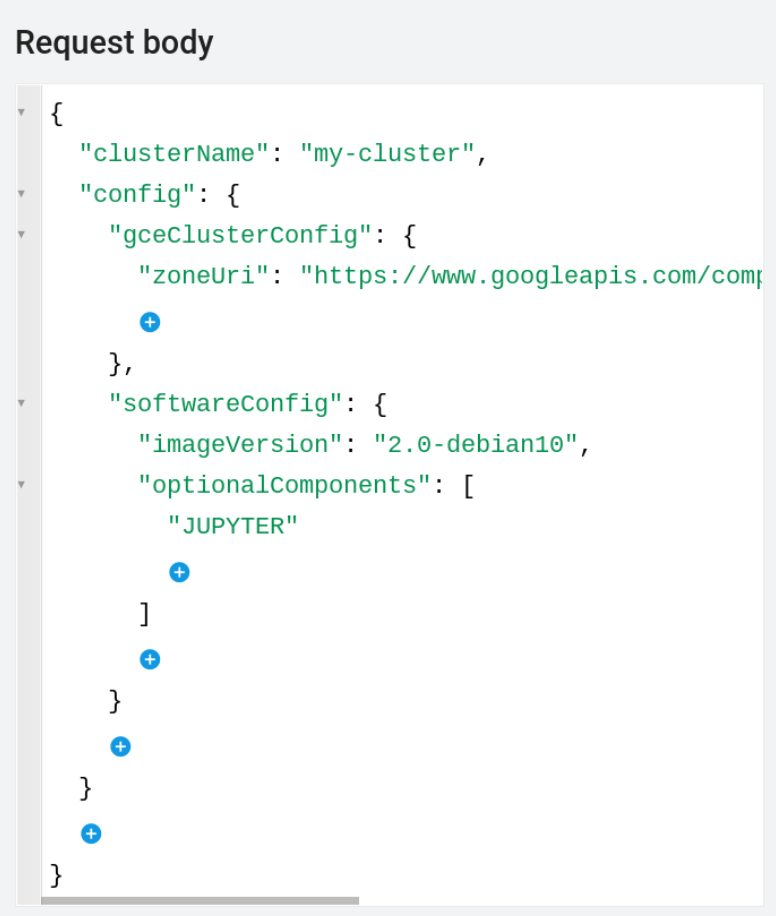

Remplissez maintenant le formulaire et exécutez le modèle APIs Explorer ci-dessous, comme suit :

- Insérez votre ID de projet Qwiklabs dans le champ "projectId".

- Définissez le champ de la région sur

. - Dans le corps de la requête, cliquez entre les accolades et ajoutez la propriété

clusterName. Saisissez le nom de cluster de votre choix. La valeur du nom de cluster (clusterName) ne doit pas contenir d'espace ni de lettre majuscule. - Dans le menu déroulant "Add a Property" (Ajouter une propriété), choisissez

config. - Dans le menu déroulant "Add a Property" (Ajouter une propriété), choisissez

gceClusterConfig. - Dans le menu déroulant "Add a Property" (Ajouter une propriété), choisissez le champ

zoneUri, puis ajoutez l'élément suivant, en remplaçantmy-project-idpar l'ID de projet de cet atelier :

- Entre les accolades se trouvant sous

config, sélectionnezsoftwareConfig. - Entre les accolades se trouvant sous

softwareConfig, sélectionnezimageVersionet définissez sa valeur sur2.0-debian10. - Entre les accolades se trouvant sous

softwareConfig, sélectionnezoptionalComponents. SousoptionalComponentscliquez sur ADD ITEM (Ajouter un élément) et sélectionnezJUPYTERdans le menu déroulant.

Une fois terminé, le corps de la requête doit ressembler à ce qui suit :

- Assurez-vous que les cases Google OAuth 2.0 et API key (Clé API) sont cochées dans la section Credentials (Identifiants).

-

Vérifiez qu'aucun champ ne se termine par une espace.

-

Maintenant, faites défiler la page vers le bas et cliquez sur Execute (Exécuter).

-

Sélectionnez le compte étudiant avec lequel vous avez commencé l'atelier.

-

Sur l'écran suivant, cliquez sur Allow (Autoriser) pour permettre à APIs Explorer d'accéder aux informations.

-

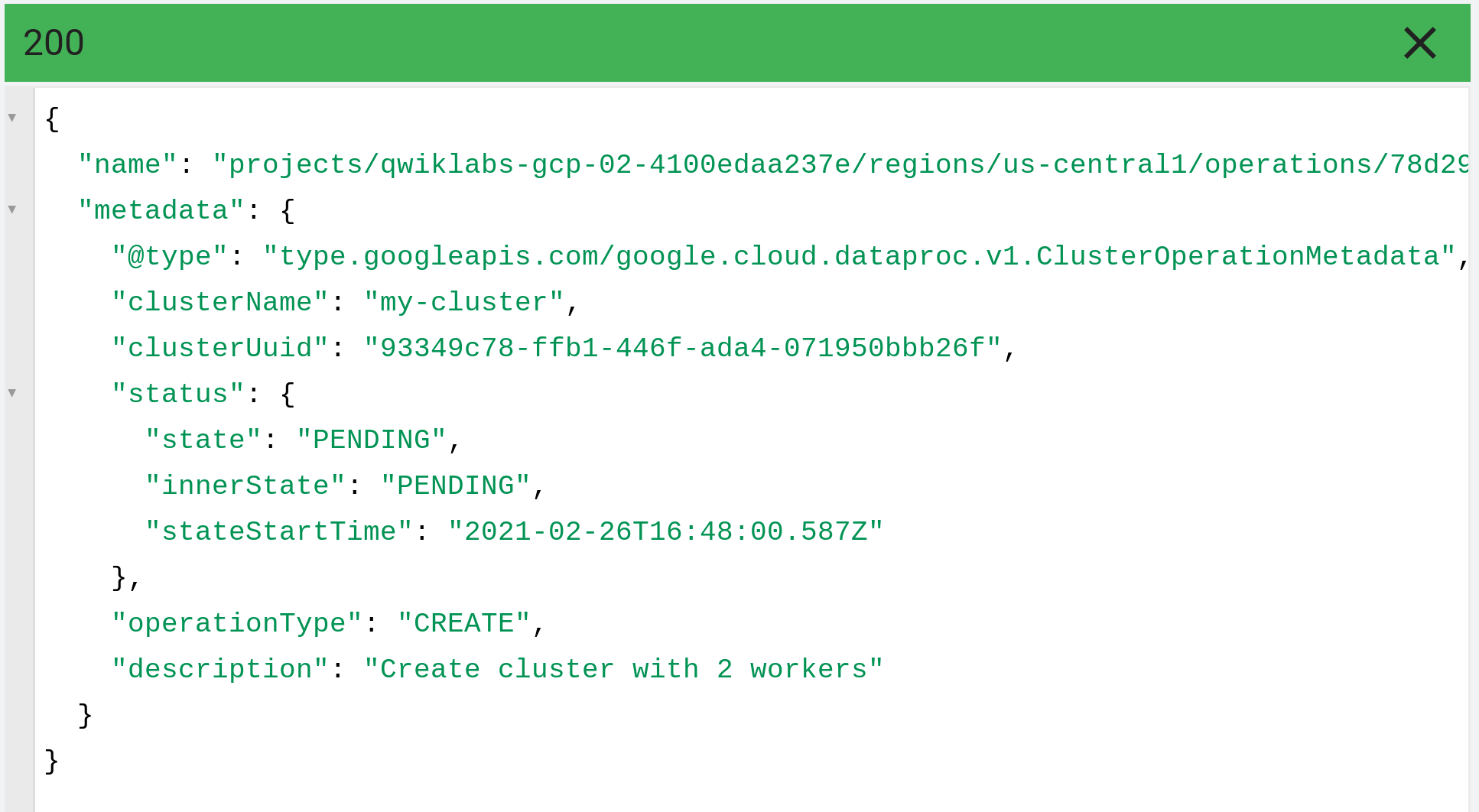

Les résultats de l'API Dataproc apparaissent sous la requête et ressemblent à ce qui suit :

- Pour visualiser le cluster créé, vous pouvez accéder au menu de navigation > Dataproc > Clusters.

Tester la tâche terminée

Cliquez sur Vérifier ma progression pour valider la tâche exécutée. Si vous avez réussi à créer un cluster Dataproc dans la région

Tâche 3 : Exécuter un job Spark

Ensuite, vous exécutez un job Apache Spark simple qui calcule une valeur approximative de pi dans un cluster Cloud Dataproc existant.

- Dans la section API et documentation de référence à gauche, accédez à Documentation de référence sur REST > v1 > projects.regions.jobs > submit pour utiliser la méthode

projects.regions.jobs.submitou cliquez sur ce lien pour envoyer un job dans un cluster.

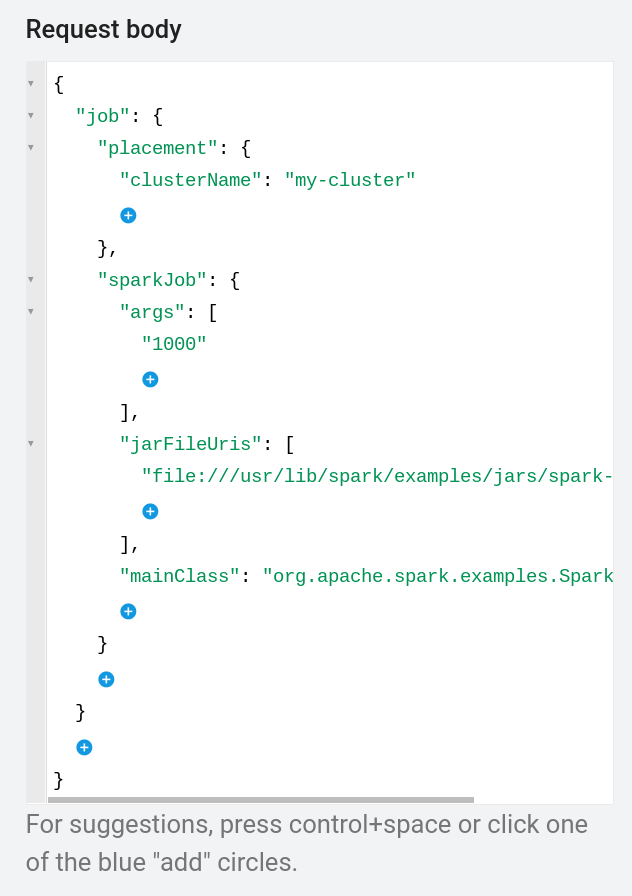

Remplissez maintenant le formulaire et exécutez le modèle APIs Explorer ci-dessous, comme suit :

- Insérez votre ID de projet dans le champ "projectId".

- Définissez le champ de la région sur

. - Dans le corps de la requête, cliquez entre les accolades et choisissez

job. - Cliquez entre les accolades en dessous et sélectionnez

placement. - Cliquez entre les accolades en dessous, sélectionnez

clusterName, puis saisissez le nom du cluster. - Entre les accolades se trouvant sous le job, sélectionnez

sparkJob. - À présent, ajoutez trois éléments sous sparkJob :

- Entre les accolades se trouvant sous sparkJob, sélectionnez

args. Sousargscliquez sur ADD ITEM (Ajouter un élément) et saisissez "1000" - Dans le menu déroulant "Add a Property" (Ajouter une propriété), choisissez

jarFileUris. SousjarFileUriscliquez sur ADD ITEM (Ajouter un élément) et saisissezfile:///usr/lib/spark/examples/jars/spark-examples.jar - Dans le menu déroulant "Add a Property" (Ajouter une propriété), choisissez

mainClasset saisissezorg.apache.spark.examples.SparkPi

Une fois terminé, le corps de la requête doit ressembler à ce qui suit :

- Assurez-vous que les cases Google OAuth 2.0 et API key (Clé API) sont cochées dans la section Credentials (Identifiants).

- Vérifiez qu'aucun champ ne se termine par une espace. Cliquez sur EXECUTE (Exécuter).

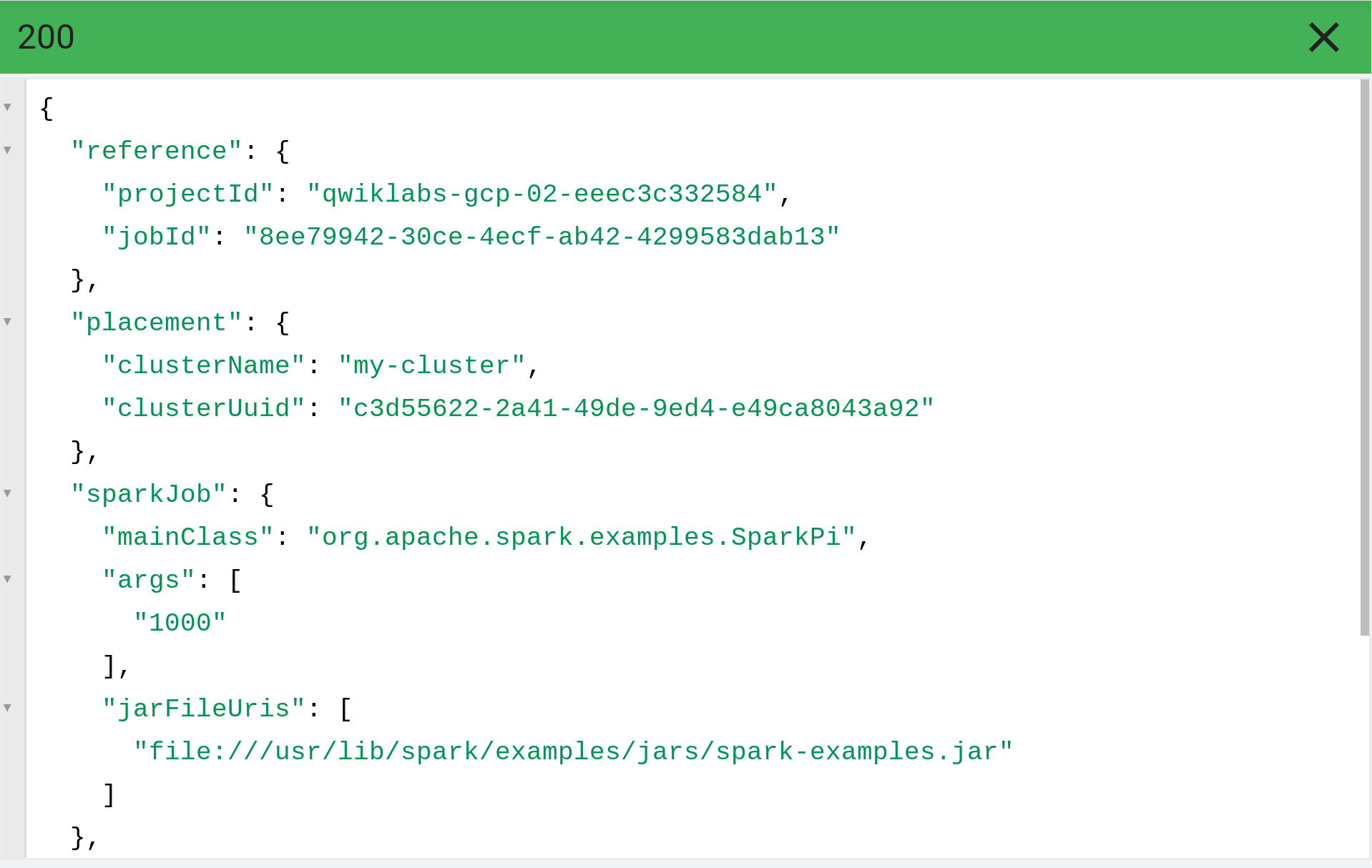

Les résultats de l'API Dataproc apparaissent sous la requête et ressemblent à ce qui suit :

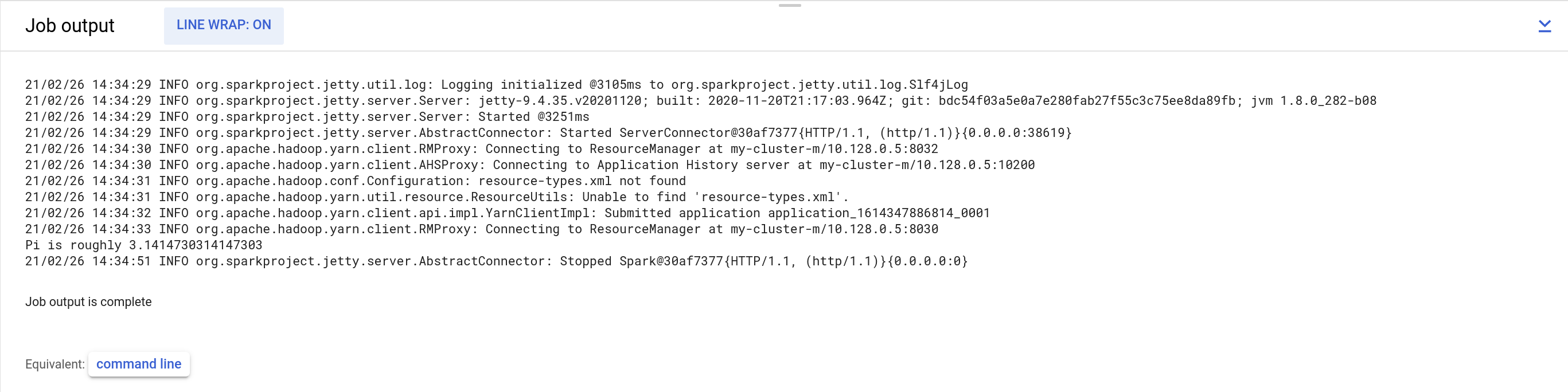

-

Pour trouver vos résultats, accédez à Dataproc > Clusters. Cliquez sur le nom de votre cluster, puis sur l'onglet Jobs.

-

Cliquez sur l'ID de job et définissez Renvoi à la ligne sur ACTIVÉ afin que les lignes dépassant la marge à droite apparaissent dans la vue.

Tester la tâche terminée

Cliquez sur Vérifier ma progression pour valider la tâche exécutée. Si vous avez réussi à envoyer un job Spark vers un cluster, vous recevrez une note d'évaluation.

Tâche 4 : Mettre à jour un cluster

- Dans la section API et documentation de référence à gauche, accédez à Documentation de référence sur REST > v1 > projects.regions.clusters > patch pour utiliser la méthode

projects.regions.clusters.patchou cliquez sur ce lien pour mettre à jour un cluster.

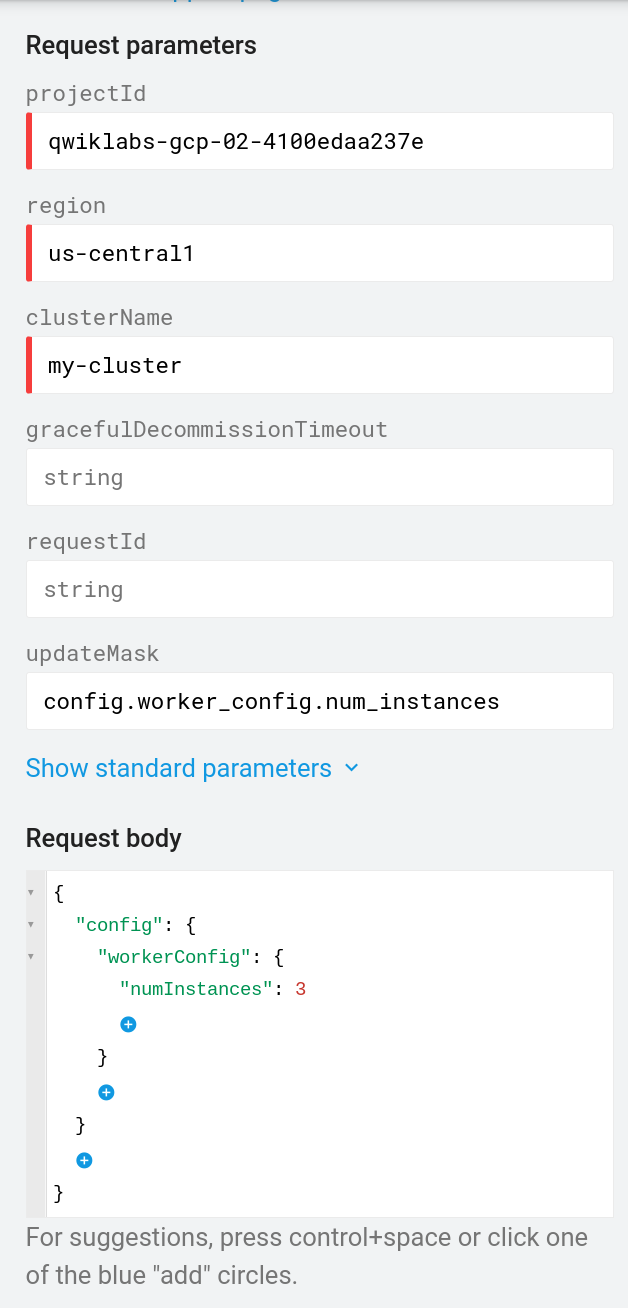

Remplissez maintenant le formulaire et exécutez le modèle APIs Explorer ci-dessous, comme suit :

- projectID = ID du projet

- region =

- clusterName = saisissez le nom du cluster

- updateMask = config.worker_config.num_instances

- Corps du correctif, saisissez les éléments suivants :

- Première accolade =

config - Cliquez entre les accolades en dessous et sélectionnez

workerConfig. - Cliquez entre les accolades en dessous, sélectionnez

numInstances, puis saisissez 3.

Votre formulaire doit se présenter comme suit :

- Assurez-vous que les cases Google OAuth 2.0 et API key (Clé API) sont cochées dans la section Credentials (Identifiants).

- Vérifiez qu'aucun champ ne se termine par une espace. Cliquez sur EXECUTE (Exécuter).

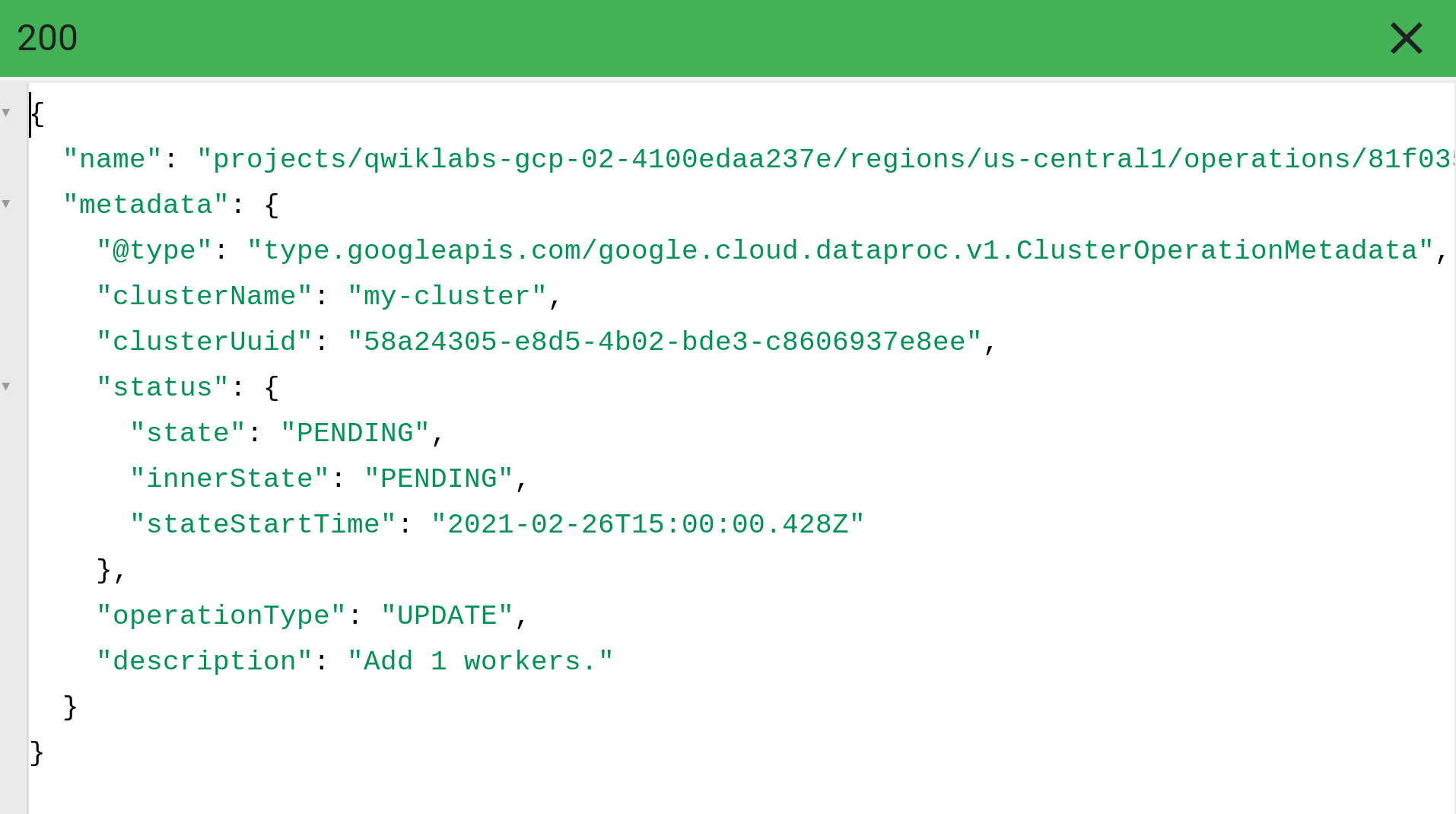

Les résultats de l'API Dataproc apparaissent sous la requête et ressemblent à ce qui suit :

- Afin de vérifier la mise à jour, revenez à la page Clusters Dataproc. Vous avez à présent un total de trois nœuds de calcul.

Tester la tâche terminée

Cliquez sur Vérifier ma progression pour valider la tâche exécutée. Si vous avez réussi à mettre à jour une configuration de nœuds de calcul pour trois nœuds de calcul, vous recevrez une note d'évaluation.

Tâche 5 : Tester vos connaissances

Voici quelques questions à choix multiples qui vous permettront de mieux maîtriser les concepts abordés lors de cet atelier. Répondez-y du mieux que vous le pouvez.

Félicitations !

Vous avez utilisé l'API Cloud Dataproc via APIs Explorer pour créer un cluster, exécuter un job Spark et mettre à jour le cluster.

Terminer votre quête

Cet atelier d'auto-formation fait partie de la quête Exploring APIs. Une quête est une série d'ateliers associés qui constituent un parcours de formation. Si vous terminez cette quête, vous obtenez un badge attestant de votre réussite. Vous pouvez rendre publics les badges que vous recevez et ajouter leur lien dans votre CV en ligne ou sur vos comptes de réseaux sociaux. Inscrivez-vous à cette quête pour obtenir immédiatement les crédits associés. Découvrez toutes les quêtes disponibles dans le catalogue Google Cloud Skills Boost.

Étapes suivantes et informations supplémentaires

- Consulter la page des questions fréquentes sur APIs Explorer

- En savoir plus sur l'API Cloud Dataproc

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière modification du manuel : 18 octobre 2023

Dernier test de l'atelier : 20 octobre 2023

Copyright 2024 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.