チェックポイント

Create a development machine in Compute Engine

/ 5

Install Software in the development machine

/ 5

Create a GCS bucket

/ 5

Download some sample images into your bucket

/ 5

Create a Cloud Dataproc cluster

/ 5

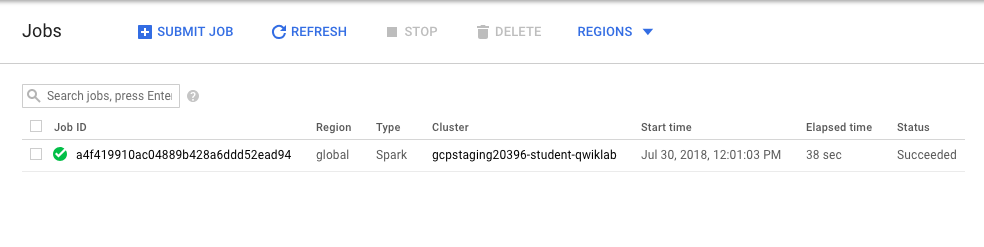

Submit your job to Cloud Dataproc

/ 5

Cloud Dataproc での分散画像処理

GSP010

概要

このハンズオンラボでは、Cloud Dataproc で Apache Spark を使用して、コンピューティング負荷の高い画像処理タスクをクラスタのマシンに分散する方法について学びます。これは科学データを処理する一連のラボの一部です。

学習内容

- Apache Spark があらかじめインストールされたマネージド Cloud Dataproc クラスタを作成する方法。

- まだクラスタにインストールされていない外部パッケージを使用するジョブを作成して実行する方法。

- クラスタをシャットダウンする方法。

前提条件

このラボは上級者向けです。Cloud Dataproc と Apache Spark の基本的な知識があることが推奨されますが、必須ではありません。これらのサービスについて学ぶには、以下のラボを受講してください。

- Dataproc: Qwik Start - コマンドライン

- Dataproc: Qwik Start - Console

- Introduction to Cloud Dataproc: Hadoop and Spark on Google Cloud

準備ができたら下にスクロールして、このラボで使用するサービスについて詳しく学んでいきましょう。

設定

[ラボを開始] ボタンをクリックする前に

こちらの手順をお読みください。ラボの時間は記録されており、一時停止することはできません。[ラボを開始] をクリックするとスタートするタイマーは、Google Cloud のリソースを利用できる時間を示しています。

このハンズオンラボでは、シミュレーションやデモ環境ではなく、実際のクラウド環境を使ってご自身でラボのアクティビティを行うことができます。そのため、ラボの受講中に Google Cloud にログインおよびアクセスするための、新しい一時的な認証情報が提供されます。

このラボを完了するためには、下記が必要です。

- 標準的なインターネット ブラウザ(Chrome を推奨)

- ラボを完了するために十分な時間を確保してください。ラボをいったん開始すると一時停止することはできません。

ラボを開始して Google Cloud コンソールにログインする方法

-

[ラボを開始] ボタンをクリックします。ラボの料金をお支払いいただく必要がある場合は、表示されるポップアップでお支払い方法を選択してください。 左側の [ラボの詳細] パネルには、以下が表示されます。

- [Google コンソールを開く] ボタン

- 残り時間

- このラボで使用する必要がある一時的な認証情報

- このラボを行うために必要なその他の情報(ある場合)

-

[Google コンソールを開く] をクリックします。 ラボでリソースが起動し、別のタブで [ログイン] ページが表示されます。

ヒント: タブをそれぞれ別のウィンドウで開き、並べて表示しておきましょう。

注: [アカウントの選択] ダイアログが表示されたら、[別のアカウントを使用] をクリックします。 -

必要に応じて、[ラボの詳細] パネルから [ユーザー名] をコピーして [ログイン] ダイアログに貼り付けます。[次へ] をクリックします。

-

[ラボの詳細] パネルから [パスワード] をコピーして [ようこそ] ダイアログに貼り付けます。[次へ] をクリックします。

重要: 認証情報は左側のパネルに表示されたものを使用してください。Google Cloud Skills Boost の認証情報は使用しないでください。 注: このラボでご自身の Google Cloud アカウントを使用すると、追加料金が発生する場合があります。 -

その後次のように進みます。

- 利用規約に同意してください。

- 一時的なアカウントなので、復元オプションや 2 要素認証プロセスは設定しないでください。

- 無料トライアルには登録しないでください。

その後このタブで Cloud Console が開きます。

はじめに

Cloud Dataproc は、オープンソースのデータツールを利用してバッチ処理、クエリ実行、ストリーミング、機械学習を行えるマネージド Spark / Hadoop サービスです。Cloud Dataproc の自動化機能を利用すると、クラスタを速やかに作成し、簡単に管理し、必要ないときには無効にして費用を節約できます。管理にかかる時間と費用が削減されるので、自分の仕事とデータに集中できます。

コンピューティング負荷の高いジョブがあり、以下の条件を満たしている場合は、Cloud Dataproc を使用してスケールアウトすることを検討してください。

- データのサブセットをそれぞれ異なるマシンで処理できる、驚異的並列ジョブである。

- 使用できる Apache Spark コードがすでにあるか、Apache Spark の基本知識がある。

- すべてのデータ サブセットの処理をほぼ均一に分散できる。

必要な処理の量がサブセットによって異なる場合(または Apache Spark の知識がまだない場合)は、自動スケーリング データ パイプラインに対応している Cloud Dataflow 上の Apache Beam が有力な選択候補となります。

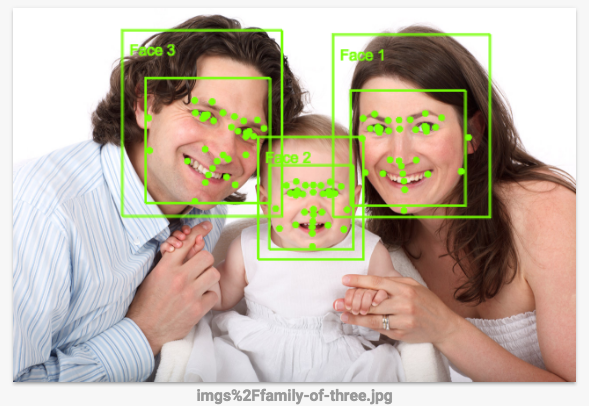

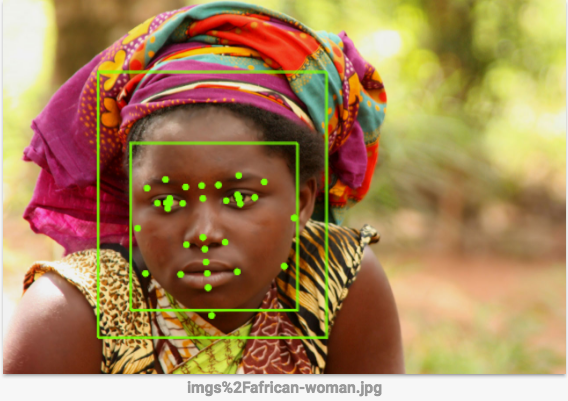

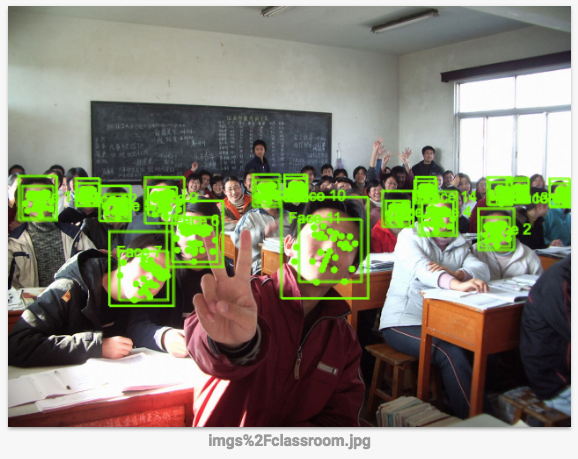

このラボでは、OpenCV で指定した一連の画像処理ルールを使用して、画像に含まれる顔を枠で囲むジョブを実行します。この種の処理には、このように手動でコーディングしたルールより Vision API の方が適していますが、このラボの目的は、コンピューティング負荷の高いジョブを分散方式で実行することにあります。

タスク 1. Compute Engine で開発マシンを作成する

まず、サービスをホストする仮想マシンを作成します。

- Cloud コンソールで、[Compute Engine] > [VM インスタンス] > [インスタンスを作成] に移動します。

-

以下のフィールドを設定します。その他のフィールドはデフォルト値のままにします。

-

名前: devhost

-

シリーズ: N1

-

マシンタイプ: 2 vCPU(n1-standard-2 インスタンス)

-

ID と API へのアクセス: すべての Cloud API に完全アクセス権を許可

-

-

[作成] をクリックします。この仮想マシンを開発用の「踏み台」インスタンスとして使用します。

完了したタスクをテストする

[進行状況を確認] をクリックして、実行したタスクを確認します。タスクが正常に完了すると、評価スコアが提供されます。

- 次に、コンソールで [SSH] ボタンをクリックして、このインスタンスに SSH 接続します。

タスク 2. ソフトウェアをインストールする

次に、ジョブを実行するソフトウェアを設定します。sbt(オープンソースのビルドツール)を使用して、Cloud Dataproc クラスタに送信するジョブの JAR をビルドします。この JAR には、プログラムと、ジョブを実行するために必要なパッケージが格納されます。このジョブでは、Cloud Storage バケットに保存されている一連の画像ファイルで顔を検出し、顔を枠で囲んだ画像ファイルを Cloud Storage の同じバケットまたは別のバケットに書き出します。

- Scala と sbt を設定します。SSH ウィンドウで、以下のコマンドを使用して

Scalaとsbtをインストールします。これにより、コードをコンパイルできるようになります。

次に、Feature Detector のファイルをビルドします。このラボのコードは、GitHub の Cloud Dataproc リポジトリに存在するソリューションを少し変更したものです。コードをダウンロードしてから、cd でこのラボのディレクトリに移動して、Feature Detector の「fat JAR」をビルドします。これを後ほど Cloud Dataproc に送信します。

- SSH ウィンドウで以下のコマンドを実行します。

- ビルドを開始します。次のコマンドを実行すると、Feature Detector の「fat JAR」がビルドされて、Cloud Dataproc に送信できるようになります。

完了したタスクをテストする

[進行状況を確認] をクリックして、実行したタスクを確認します。タスクが正常に完了すると、評価スコアが提供されます。

タスク 3. Cloud Storage バケットを作成して画像を収集する

Feature Detector のファイルがビルドされたら、Cloud Storage バケットを作成してサンプル画像をいくつか追加します。

- バケットの名前に使用するため、プロジェクト ID を取得します。

- バケットに名前を付けて、その名前にシェル変数を設定します。このシェル変数をコマンドで使用してバケットを参照します。

-

gcloudとともに Cloud SDK に含まれているgsutilプログラムを使用して、サンプル画像を保存するバケットを作成します。

完了したタスクをテストする

[進行状況を確認] をクリックして、実行したタスクを確認します。タスクが正常に完了すると、評価スコアが提供されます。

- 作成したバケットにサンプル画像をダウンロードします。

以下の画像が Cloud Storage バケットにダウンロードされます。

完了したタスクをテストする

[進行状況を確認] をクリックして、実行したタスクを確認します。タスクが正常に完了すると、評価スコアが提供されます。

- 次のコマンドを実行してバケットの内容を確認します。

出力:

タスク 4. Cloud Dataproc クラスタを作成する

-

SSH ウィンドウで以下のコマンドを実行して、クラスタに名前を付けて

MYCLUSTER変数を設定します。この変数をコマンドで使用してクラスタを参照します。

- 使用するグローバルの Compute Engine ゾーンを設定し、新しいクラスタを作成します。

- リージョンではなくゾーンを使用するよう求めるプロンプトが表示された場合は、「Y」を入力します。

完了までに数分かかります。このラボでは、2 つのワーカーノードを含むデフォルトのクラスタ設定で十分です。クラスタで使用されるコアの総数を減らすために、ワーカーとマスターの両方のマシンタイプに n1-standard-2 を指定しています。

initialization-actions フラグでは、クラスタの各マシンに libgtk2.0-dev ライブラリをインストールするスクリプトを渡します。このライブラリはコードを実行するために必要となります。

gcloud dataproc clusters delete ${MYCLUSTER})、前のクラスタ作成コマンドを再試行してください。

完了したタスクをテストする

[進行状況を確認] をクリックして、実行したタスクを確認します。タスクが正常に完了すると、評価スコアが提供されます。

タスク 5. Cloud Dataproc にジョブを送信する

このラボで実行するプログラムは顔検出に使用されるため、顔を表す haar 分類器を入力する必要があります。haar 分類器とは、プログラムで検出する特徴を記述するために使用される XML ファイルです。ここでは、haar 分類器のファイルをダウンロードし、Cloud Dataproc クラスタにジョブを送信する際にその Cloud Storage パスを最初の引数として指定します。

- SSH ウィンドウで次のコマンドを実行して、顔検出の構成ファイルをバケットに読み込みます。

- Cloud Storage バケットの

imgsディレクトリにアップロードした一連の画像を Feature Detector への入力として使用します。そのディレクトリのパスをジョブ送信コマンドの 2 番目の引数として指定する必要があります。

- Cloud Dataproc にジョブを送信します。

処理する他の画像を、2 番目の引数で指定した Cloud Storage バケットに追加することもできます。

- Cloud コンソールでナビゲーション メニュー > [Dataproc] > [ジョブ] に移動して、ジョブを監視します。

以下のような出力が表示されたら次のステップに進みます。

完了したタスクをテストする

[進行状況を確認] をクリックして、実行したタスクを確認します。タスクが正常に完了すると、評価スコアが提供されます。

-

ジョブが完了したら、ナビゲーション メニュー > [Cloud Storage] に移動し、作成したバケット(ユーザー名の後に

student-imageと乱数が追加された名前のバケット)を見つけてクリックします。 -

Out ディレクトリにある任意の画像をクリックします。

-

[ダウンロード] アイコンをクリックすると、その画像がパソコンにダウンロードされます。

顔検出は正確に機能していますか。この種の処理には、このように手動でコーディングされたルールより Vision API の方が適しています。次のステップで確認してみましょう。

-

(省略可)作成したバケットの

imgsフォルダに移動して、アップロードした他の画像をクリックし、3 つのサンプル画像をダウンロードしてパソコンに保存します。 -

このリンクをクリックして Vision API のページに移動し、[Try the API] セクションまでスクロールして、バケットからダウンロードした画像をアップロードします。数秒で画像検出の結果が表示されます。基盤となる機械学習モデルは継続的に改良されているため、実際の結果は以下と異なる場合があります。

- (省略可)Feature Detector の改良に挑戦してみてください。

FeatureDetectorのコードを編集して、sbt assembly、gcloud dataprocとjobs submitコマンドを再実行します。

タスク 6. 理解度チェック

今回のラボで学習した内容の理解を深めていただくため、以下の選択式問題を用意しました。正解を目指して頑張ってください。

お疲れさまでした

ここでは、Cloud Dataproc クラスタを作成してジョブを実行する方法を学習しました。

クエストを完了する

このセルフペース ラボは、「Scientific Data Processing」クエストの一部です。クエストとは学習プログラムを構成する一連のラボのことで、完了すると成果が認められてバッジが贈られます。バッジは公開して、オンライン レジュメやソーシャル メディア アカウントにリンクできます。このラボの修了後、こちらのクエストに登録すれば、すぐにクレジットを受け取ることができます。受講可能な全クエストについては、Google Cloud Skills Boost カタログをご覧ください。

次のラボを受講する

「Datalab と BigQuery による出生率データの分析」に進んでクエストを続けるか、以下のおすすめのラボをご確認ください。

Google Cloud トレーニングと認定資格

Google Cloud トレーニングと認定資格を通して、Google Cloud 技術を最大限に活用できるようになります。必要な技術スキルとベスト プラクティスについて取り扱うクラスでは、学習を継続的に進めることができます。トレーニングは基礎レベルから上級レベルまであり、オンデマンド、ライブ、バーチャル参加など、多忙なスケジュールにも対応できるオプションが用意されています。認定資格を取得することで、Google Cloud テクノロジーに関するスキルと知識を証明できます。

マニュアルの最終更新日: 2023 年 7 月 18 日

ラボの最終テスト日: 2023 年 7 月 18 日

Copyright 2024 Google LLC All rights reserved. Google および Google のロゴは Google LLC の商標です。その他すべての企業名および商品名はそれぞれ各社の商標または登録商標です。

![[インスタンスを作成] ボタンへのナビゲーション パス。ハイライト表示されている](https://cdn.qwiklabs.com/3U1qCvvhTTw%2BqvK%2FuZxEnB2BZXmH%2BF3lPefxGzP6EK0%3D)

![ステップ 2 で説明するフィールドに値が入力された [インスタンスを作成] ページ。](https://cdn.qwiklabs.com/PnHgE21sSnhSte4BOlumZ2%2F2qxMk8fSZVuo6s4vkxS0%3D)